100 Kilobyte pro Schraubvorgang

Vom Sensor in die Cloud

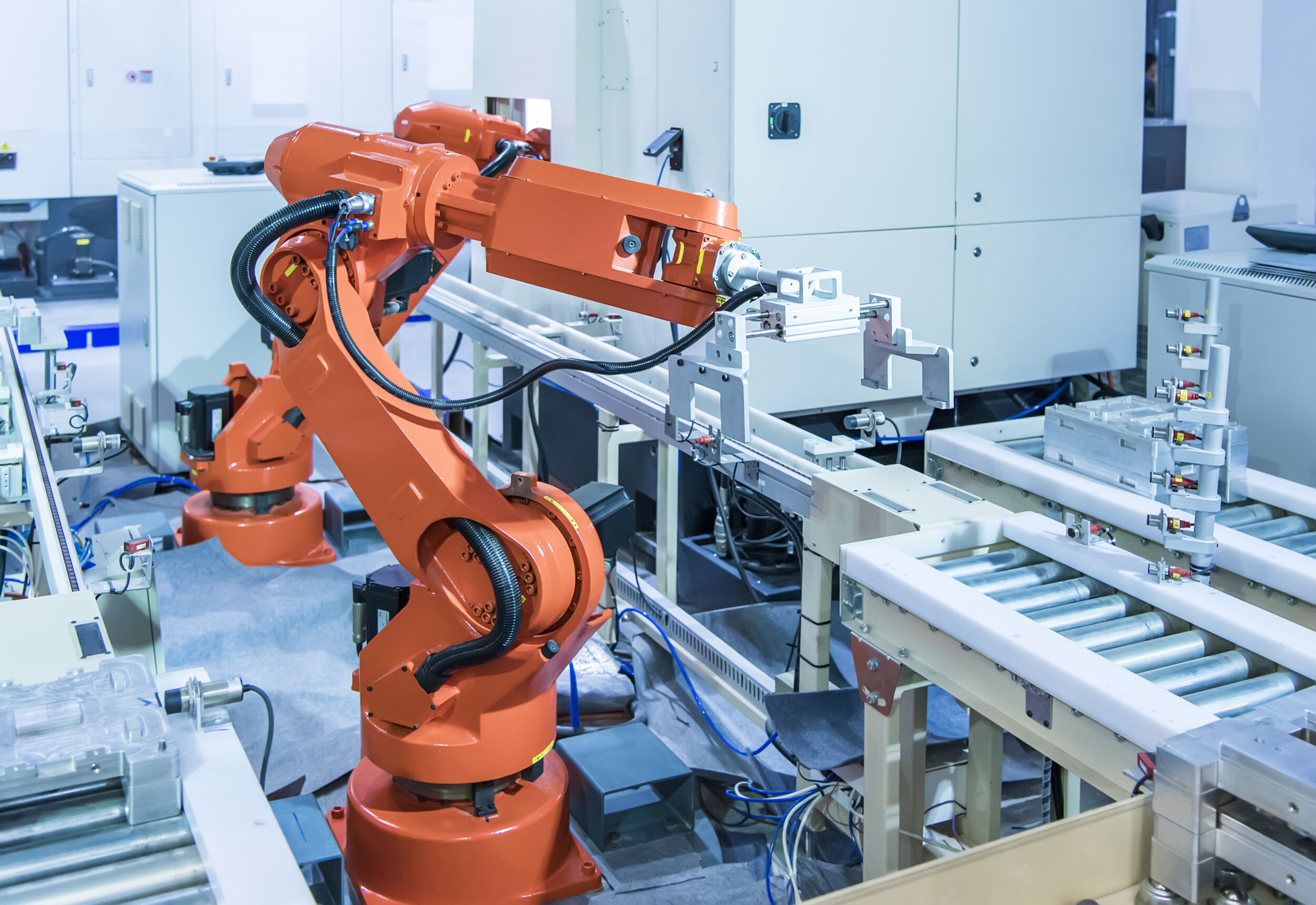

Durch die Verknüpfung von Maschinen und Objekten lassen sich Erkenntnisse gewinnen, welche die Wertschöpfungskette entscheidend verbessern können. Doch vorher muss geklärt werden, wie sich Daten im vernetzten Produktionsumfeld sicher gewinnen und sinnvoll auswerten lassen.

Daten sind der Rohstoff des 21. Jahrhunderts. Eine Herausforderung besteht darin, sie effektiv zu nutzbringenden Informationen zu verarbeiten. Laut einer Studie der EMC Corporation wird sich bis 2020 das Datenvolumen allein in Deutschland von 230 auf 1.100 Milliarden Gigabyte steigern. Für die deutsche Industrie liegt in der Anwendung der intelligenten Fabrik und der intelligenten Auswertung der daraus entstehenden Daten die Möglichkeit, ihren Produktionsstandort wettbewerbsfähiger zu halten. Die Analyse der Daten aus der Produktion, Instandhaltung, Logistik und anderen Bereichen entlang der Wertschöpfungskette kann dazu beitragen, die Prozesse der Fertigung effizienter zu gestalten. Darüber hinaus werden neue Geschäftsmodelle entstehen, die das Potential zur Erschließung neuer Märkte haben. Doch wie lassen sich diese große Datenvolumen und die vielen Informationen, die laufend produziert werden, verwalten und kontrollieren, damit aus Daten Wissen und aus Wissen Nutzen entsteht. Das Manufacturing Execution System (MES) HYDRA optimiert Produktionsprozesse für Fertigungsunternehmen, um Wettbewerbsvorteile zu erzielen. ‣ weiterlesen

MES-Integrator und 360-Grad-Partner für optimierte Fertigung

Lokal oder dezentral

Im Produktionsumfeld entstehen fortwährend Daten: Bei komplexen Abläufen, wie etwa einem Schraubvorgang, werden rund 100 Kilobyte an Daten generiert – bei einfachen Abläufen vielleicht jede Millisekunde nur wenige Bytes. Doch hochgerechnet auf eine Produktionslinie entstehen so schnell große Datenmengen. Diese Daten lassen sich von einer Software erfassen und zur Informationsgewinnung automatisiert analysieren. Dabei gibt es je nach Ort der Datenverarbeitung zwei unterschiedliche Ansätze:

- Daten werden direkt an der Maschine weiterverarbeitet oder

- in eine Cloud-Umgebung übermittelt.

Auch eine Kombination beider Ansätze kann sinnvoll sein. Entscheidend für die Wahl des Ansatzes ist der Zweck, den die Datengewinnung und -verarbeitung erfüllen soll. Eine maschinennahe Datenanalyse ist sinnvoll, wenn eine sehr große Datenmenge vorliegt und sich daraus nutzbare Erkenntnisse gewinnen lassen, auch ohne dass Informationen von anderen Maschinen, Objekten oder der Umgebung hinzugezogen werden. Betrachtet man zum Beispiel einen Temperatursensor, der jede Millisekunde einen Sensorwert bereitstellt, so ist eine maschinennahe Analyse sinnvoll, falls sichergestellt werden soll, dass die Temperatur nicht über einen bestimmten Schwellwert steigt.

Wird auf Basis der Analyse die Überschreitung des Schwellwerts erkannt, wird ein Event mit wesentlichen Informationen generiert und in die Cloud übertragen. Würden die einzelnen Sensorwerte über das Netzwerk in die Cloud weitergegeben werden, würde dies, auf das gesamte System gesehen, eine hohe Netzwerklast verursachen. Allerdings sind in diesem Fall die Daten zunächst nur lokal verfügbar und können nicht anderweitig genutzt werden. Die Sammlung der Sensorwerte in einer Datei und deren periodische Übermittlung an die Cloud könnte das Problem lösen. Eine zentrale Bereitstellung der Daten in der Cloud kommt in Frage, um Informationen durch die Analyse der Daten einer Maschinengruppe zu ermitteln oder wenn die Daten für andere Anwendungen relevant sind.