KI-Applikationen pflegen

Weshalb auch eine KI ‚altert‘

Der Einsatz von künstlicher Intelligenz (KI) verspricht Industrieunternehmen Wettbewerbsvorteile. Doch KI-Systeme zu überwachen und an neue Voraussetzungen anzupassen, ist oft umständlich oder unterbleibt ganz. Neue Ansätze sollen das ändern.

Erst vor Kurzem hat das Fraunhofer IAIS in Zusammenarbeit mit Munich RE eine Zertifizierungsmöglichkeit für künstliche Intelligenz geschaffen. Denn Software, die mit KI ausgestattet ist und z.B. Qualitätsprognosen auf Basis von so genannten Machine-Learning-Modellen erstellt, darf nicht nur zum Start geprüft, sondern muss permanent überwacht werden. Der Grund dafür ist ein Problem, das Betreiber oft wenig beachten, das aber mit dem zunehmenden Einsatz von KI-Software sichtbarer wird: Machine-Learning-Modelle werden mit der Zeit immer ungenauer und unzuverlässiger. Dieser Alterungsprozess wird als Model Drift bezeichnet und ist in Fachkreisen ein bekanntes Phänomen. Mit abnehmender Verlässlichkeit der KI-Modelle nimmt auch deren Nutzen ab – der dahinterstehende Business Case könnte kippen.

Was verbirgt sich hinter dem Alterungsprozess?

Ein Missverständnis in der KI-Welt ist die Annahme, dass alle Algorithmen von allein und fortwährend dazulernen. In der Realität ist das nur in einigen, speziellen Fällen umgesetzt und oft mit hohem Aufwand verbunden. Gerade in Industrieanwendungen, in denen Sensordaten eine zentrale Rolle spielen, lernen die Modelle zunächst basierend auf den Daten der Vergangenheit (Training). Aus den dort gelernten Mustern erzeugen die Modelle dann ihre Vorhersage. Und hier offenbart sich das Alterungs-Problem: Die Bedingungen der Vergangenheit haben sich zur Gegenwart hin verändert und tun dies fortwährend. Dabei handelt es sich oft nur um kleine Nuancen, die aber erheblichen Einfluss auf die Vorhersagegenauigkeit des Gesamtmodells haben können. Die Frage ist also, welche äußeren Einflüssen lassen das KI -Modell altern? Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

Daten verändern sich

Ein Beispiel: In einem industriellen Reinigungsprozess werden Bauteile mittels eines automatisierten Verfahrens gesäubert. Dieser Prozess erstreckt über mehrere Tauchbäder unterschiedlicher Säure- und Basenkonzentrationen. Viele Faktoren haben Einfluss auf die Reinigungsqualität der Bauteile. Die Aufgabe der KI ist es, die finale Reinigungsqualität frühzeitig vorherzusagen, um bei negativen Abweichungen in den Prozess einzugreifen zu können oder diesen sogar abzubrechen. Bei der Modellerstellung werden zunächst Annahmen über die möglichen Einflussfaktoren auf die Reinigungsqualität getroffen, etwa Säurekonzentration, Temperatur oder Verschmutzungsgrad der Teile. Sensoren erfassen die dafür notwendigen Daten, welche über einen möglichst repräsentativen Zeitraum gespeichert werden. Diese Daten der Vergangenheit bilden die Basis für das Modell-Training. Basierend auf den aktuellen Messungen und der Kenntnis über die Vergangenheit trifft das Modell dann seine Entscheidung bzw. die Vorhersage. So kann das Modell im Beispiel früh vorhersagen, ob sich am Ende etwa Qualitätsprobleme ergeben werden und entsprechend warnen. Die aktuellen Daten des Prozesses sind jedoch nicht zu 100 Prozent mit den historischen Daten vergleichbar. Beispielsweise können Sensoren verschmutzen oder durch ihren eigenen Lebenszyklus leicht veränderte Werte liefern. Verändern sich also die aktuellen Daten im Vergleich zu denen, die bei der Erstellung des Modells verwendet wurden, spricht man von einem so genannten ‚Data Drift‘. Oder vereinfacht dargestellt: Wenn der Luftdrucksensor in einem Autoreifen durch äußere Einflüsse immer ungenauere Werte liefert, wird auch die Vorhersage zur Reifengesundheit immer schlechter.

Voraussetzungen ändern sich

Machine Learning-Modelle haben mit einer weiteren Veränderungsgröße zu kämpfen, dem sogenannten ‚Concept Drift‘. Bezogen auf das Beispiel der Reinigungsbadoptimierung bedeutet das: Wurden die Daten für das Modell-Training ausschließlich für Teile erfasst, die in geschützten Hallen verwendet werden, sind die konzeptionellen Voraussetzungen für Bauteile im Außeneinsatz deutlich verschieden. Die Bedingungen für den Verschmutzungsgrad sind grundlegend anders. Es ist also zu erwarten, dass das Vorhersagemodell eine unzutreffende Aussage zur Reinigungsqualität machen wird. Etwas vereinfacht und bezogen auf den Autoreifen-Fall bedeutet das: Wurde das Modell zur Vorhersage der Reifengesundheit lediglich auf erhobenen Daten im Sommer trainiert, dürfte das Verhalten im Winter deutlich abweichen.

Qualität laufend überwachen

Der Model Drift kann negative Auswirkungen auf den Prozesserfolg. Folglich sollte auch die Qualität der eingesetzten KI-Modelle überwacht werden. Erschwerend kommt hinzu, dass diese Qualitätsprüfung (Validierung) ein mindestens ebenso komplexes Verfahren wie die Erstellung der Modelle selbst ist. Die Validierung besteht aus verschiedenen Tests, um Qualität und Güte des Modells in verschiedenen Bereichen und Aspekten zu prüfen. Je nach Einsatzgebiet, Anwendungsfall und Datenverfügbarkeit kann es schwierig sein, überhaupt sinnvolle Strategien und aussagekräftige Bewertungssysteme für die Validierung zu finden. Die Wahl der Maßstäbe und Metriken für Erklärbarkeit und Nachvollziehbarkeit bestimmter Algorithmen und deren Validierung sind komplex und zum Teil noch Gegenstand aktueller Forschungen. Zudem kann eine fahrlässig gewählte Validierungsstrategie völlig falsche Aussagen liefern. Wie herausfordernd solche Überwachungen werden können, ergibt sich aus der Menge der möglichen Einflussgrößen. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Werkzeuge für Spezialisten

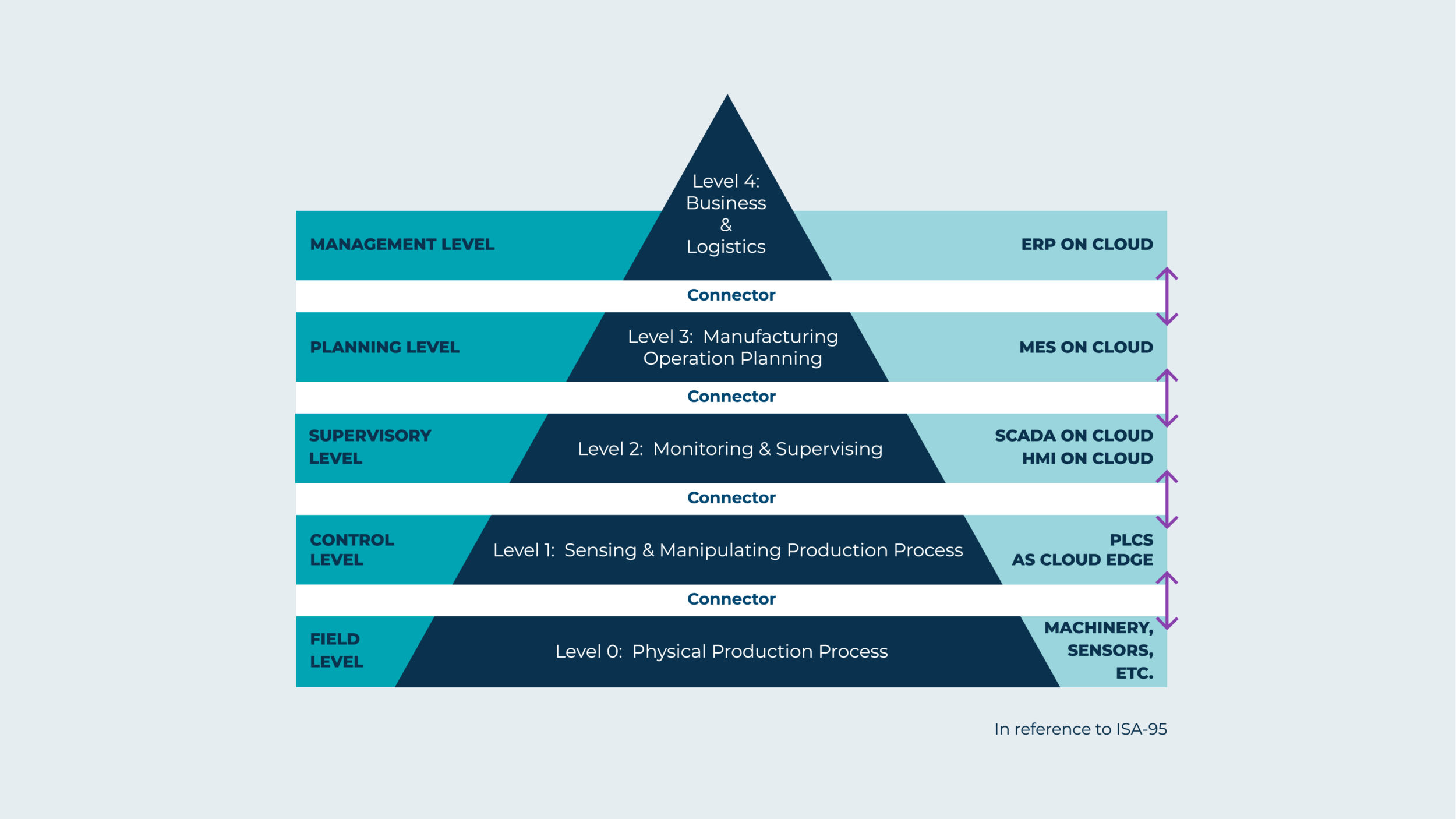

Die Notwendigkeit der Qualitätsüberwachung und die Auswirkungen des Model Drift sind keine Neuigkeit. Es gibt immer mehr Werkzeuge, mit denen sich Model Drift erkennen lässt. Die Modellüberwachung in solchen Werkzeugen ist oft nur ein Modul von vielen und das Monitoring wird in Verbindung mit dem gesamten Management des Model-Lebenszyklus quasi mit erledigt. Damit einher gehen oft nur begrenzte und ungeeignete Methoden zur Qualitätskontrolle. Des Weiteren handelt es sich bei diesen Anwendungen oft selbst um komplexe Systeme oder Plattformen, die für KI-Spezialisten ausgelegt wurden. Sie werden von Data-Scientisten und Machine-Learning Software-Ingenieuren genutzt und unterstützen in erster Linie deren Arbeit. Unternehmen, die KI als ein Stück Software nutzen wollen, können heute zwischen dem Aufbau eines eigenen Data-Science-Teams, dem internen Betrieb einer Software-Plattform oder dem Abo in einer Cloud-Lösung wählen. Auf die Unternehmen kommen somit zusätzliche Investitionen und Risiken zu, entweder durch zusätzlichen Personalaufwand oder eine Erhöhung der gesamten Systemkomplexität inklusive Datensicherheitsfragen bei Cloud-Lösungen.

Neue Ansätze sind gefragt

Viele Unternehmen kennen den Schmerz der computergestützten Automatisierung und heute der Digitalisierung. Die IT hilft zwar, effizientere Prozesse einzurichten oder neue zu gestalten, kommt dann aber selbst mit einer eigenen Komplexität und zusätzlichen Investitionen daher. Software, die mittels künstlicher Intelligenz und Machine-Learning weitere Potenziale heben soll, fügt eine weitere Komplexitätsstufe in der IT-Landschaft hinzu. Der eigentliche Nutzen wird so aus unternehmerischer Sicht immer kleiner. Um den KI-Einsatz auch für Unternehmen zu ermöglichen, die keine eigene und große IT betreiben wollen oder können, konzentrieren sich Startups auf die Sicherung des reinen KI-Nutzenversprechens und bieten die Validierung als einen eigenen Service an. So hat sich beispielsweise Anfang 2022 im thüringischen Jena das Startup Phnx Alpha gegründet. Die Validierungsspezialisten fokussieren sich mit ihren Lösungen rein auf das Modellmonitoring und die Validierung im industriellen Umfeld: „Unser AI Guard ist vergleichbar mit einem Fitness Tracker für Modelle und kann sehr nah an oder direkt auf der Maschine oder dem industriellen Prozess eingesetzt werden. Dafür bedarf es weder Spezialisten noch einer zusätzlichen Software. Außerdem verbleiben die Prozessdaten im Unternehmen und werden nicht in die Cloud geschickt,“ sagt Mitgründerin Konstanze Olschewski. Das Angebot ist als Baustein zu verstehen, um den Zugang und die Qualitätssicherung von KI-Lösungen einem breiteren Spektrum von Unternehmen zu öffnen, ohne dass größere Investitionen getätigt oder Sicherheitsrisiken entstehen. Die Entwicklungen der kommenden Jahre werden zeigen, ob das gelingt.