Der Accelerated-Discovery-Ansatz

KI, Cloud und Quantenrechner als Turbo für Entdeckungen

Die Sprints zu Covid19-Impfstoffen zeigen den Leistungsdruck, unter dem die Technologieentwicklung steht. In kürzester Zeit sollen Forscher und Ingenieure Lösungen für die kritischen Probleme unserer Zeit finden. Der Accelerated-Discovery-Ansatz soll helfen, Forschungs- und Entwicklungsprozesse mit KI, Hybrid Cloud und schließlich Quantencomputern um das zehn- bis hundertfache des heute Möglichen zu beschleunigen.

Noch nie zuvor waren die Erwartungen an die Forschung so hoch, drängende Probleme schnell zu lösen. Es geht nicht mehr nur um theoretische Antworten, sondern auch darum, Entwicklungszeiten bis zur Einsatzfähigkeit von Produkten immer weiter zu reduzieren. Nicht nur Impfstoffe und Medikamente werden akut gebraucht, sondern auch Materialien, um andere Herausforderungen zu bewältigen. Deren Bandbreite reicht von künftigen Pandemien über den Klimawandel, Ressourcenknappheit, Mobilität bis zu einer sauberen und ungefährlichen Energieversorgung bei steigendem Bedarf. Und damit ist die Liste längst noch nicht komplett.

Forschen im Zeitraffer

Viele dieser Fragen dulden keinen Aufschub und auch keine Abstriche in der Qualität, insbesondere wenn es um unkalkulierbare Risiken geht, wie das im Pharmabereich der Fall sein kann. Die Quintessenz: Wissenschaftliches Arbeiten muss schneller werden, die vorgelegten Resultate müssen dennoch sicher sein – ein klassischer Zielkonflikt. Das Konzept Accelerated Discovery setzt hier an, indem es den wissenschaftlichen Arbeitsprozess technologiegetrieben deutlich beschleunigt. Teflon, Vaseline, Mikrowellen, Röntgenstrahlen oder Graphen, das als Werkstoff der Zukunft gehandelt wird, wurden alle durch Zufall entdeckt. Und nicht selten verging noch einige Zeit, bis deren Potenzial erkannt wurde. Bereits ab den 1950er Jahren sorgten Computer für eine Beschleunigung wissenschaftlicher Prozesse und machten Erfolge wie etwa die Mondlandung möglich. Heute machen Fortschritte auf verschiedenen Technologiefeldern die Modellierung und Simulation komplexer Moleküle mit Hilfe von künstlicher Intelligenz (KI) möglich. Big-Data-getriebene Wissenschaft kann die Phasen des Erkenntnisprozesses – Fragestellung, Recherche, Formulierung einer Hypothese, Experimente, um die Hypothese zu testen, Verifizierung oder Falsifizierung der Hypothese – schneller durchlaufen als je zuvor. Aber selbst mit Hochleistungscomputern ist der Forschungsprozess noch zu langsam. Nach wie vor dauert es Jahre und kostet Millionen, um beispielsweise ein neues Material mit bestimmten Eigenschaften zu entwickeln. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Material schneller entwickeln

Der Einsatz von KI in der Materialwissenschaft ist nicht neu. Doch die Art ihrer Nutzung verändert sich. Sie wird nicht mehr nur genutzt, um Eigenschaften eines bekannten Materials vorherzusagen, sondern um die gezielte Entwicklung neuer Materialien mit vorher definierten und erwünschten Eigenschaften zu ermöglichen. Die Unterstützung setzt schon bei der Prüfung der Literatur an. Jedes Jahr werden mehr als zwei Millionen Fachbeiträge in 30.000 wissenschaftlichen Publikationen veröffentlicht – der menschliche Leser benötigt aber ein bis zwei Minuten pro Seite. Nach der Recherche folgt ein iterativer Zyklus von Synthese, Charakterisierung und Tests, bis eine zufriedenstellende Verbindung gefunden ist. Der Cloud-basierte KI Service von IBM Research namens Deep Search erfasst hingegen 20 Seiten pro Sekunde. Auf der Suche nach einem neuen Fotosäure-Generator (PAG) ließen IBM-Forscher via Deep Search 6.000 Artikel und Patente durchsuchen. Erste Erkenntnis: Wichtige Eigenschaftsdaten für die vielversprechendsten Verbindungen fehlten in der Literatur fast völlig. Daher sollte eine KI-gestützte Simulation ein so genanntes generatives Modell erstellen und trainieren. Ein generatives Modell ist eine KI-Technologie, die, nachdem sie mit einem Datensatz trainiert wurde, automatisch neue Objekte mit Eigenschaften generiert, die den ursprünglichen Daten ähnlich sind.

Simulieren und Generieren

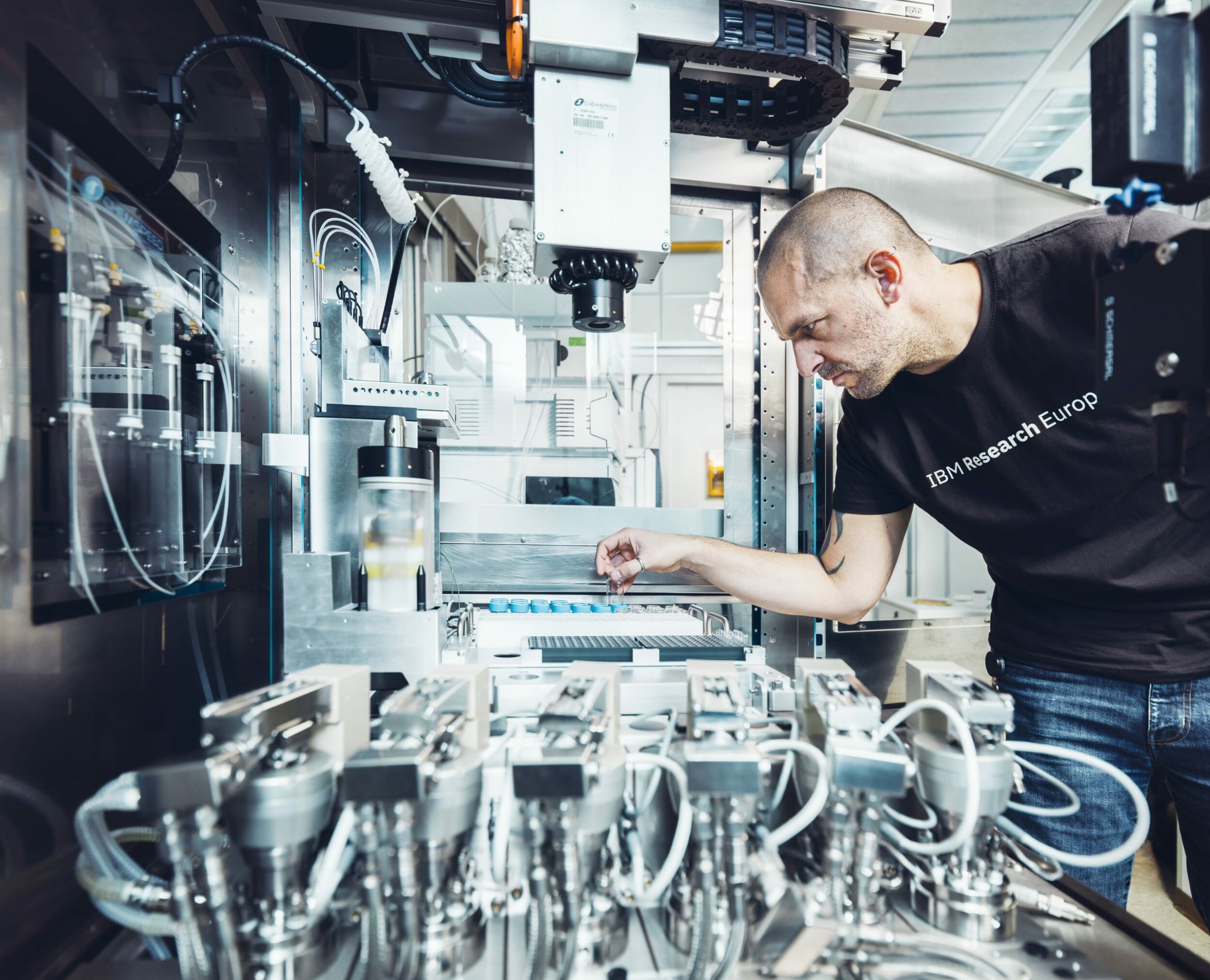

Die Forscher trainierten das Modell mit den vorhandenen PAG-Struktur- und Eigenschaftsdaten. Anschließend begann das System, neue PAG-Strukturen mit verbesserten Umwelteigenschaften bei gleichbleibend hoher Lichtempfindlichkeit zu entwerfen. Das Ergebnis: Das generative KI-Modell erzeugte etwa 2.000 potenzielle PAG-Kandidaten in fünf Stunden. Da auch die Bewertung dieser Vielzahl von Ergebnissen durch menschliche Experten viel Zeit in Anspruch nehmen würde, kam auch bei der Auswahl der vielversprechendsten Kandidaten KI zum Einsatz. Zudem half ein KI-basiertes Retrosynthese-Tool, den besten Weg zur Herstellung organischer Moleküle zu identifizieren. Am Ende stand ein in einem KI-gesteuerten, automatisierten Labor synthetisierter PAG, der die Anforderungen erfüllt. Das Beispiel zeigt, wie Technologie die Materialforschung beschleunigen kann, indem sie die Zeit für die Suche und Synthese eines neuen Moleküls von Jahren auf Monate reduziert. Übrigens: Die Gefahr, dass der Mensch dabei überflüssig wird, besteht nicht. Die KI durchsucht menschliches Expertenwissen und ist letztlich auf die Kreativität und Innovationsstärke ihrer menschlichen Nutzer angewiesen.

Wo sich Mensch und KI treffen

Die im Projekt eingesetzte Hybrid Cloud-Plattform trug entscheidend zum Erfolg bei. Workloads lassen sich so auf der am besten geeigneten Hardware ausführen, egal ob es sich dabei um klassische Computer, Quantencomputer, eine Kombination aus beiden oder speziell entwickelte KI-Hardware handelt. Zugleich bildet die Hybrid Cloud auch die Plattform für die Zusammenarbeit interdisziplinärer Teams, die im Rahmen eines offenen Informationsaustauschs auf einer gemeinsamen, offenen Infrastruktur an einem Projekt arbeiten. Mit Hybrid Cloud entwarfen die beteiligten Forscher den Arbeitsprozess, mit dessen Hilfe die neuen PAG-Kandidaten zwei bis drei Mal schneller hergestellt werden als mit herkömmlichen Verfahren.

Bereit für neue Hardware

Selbst mit heutigen Supercomputern sind nicht alle Probleme lösbar. Quantencomputer werden das ändern. Auf dem Prinzip der Quantenmechanik aufbauend arbeiten sie mit probabilistischen Algorithmen, die Wahrscheinlichkeiten für bestimmte Resultate liefern. Auf diese Weise gibt das System die wahrscheinlichste Antwort schneller und viel genauer, als es ein klassischer Computer je könnte. Die grundlegende Arbeitseinheit für einen Quantencomputer ist ein Circuit. Diese Circuits werden mit klassischen cloudbasierten Ressourcen kombiniert, um neue Algorithmen, wiederverwendbare Software-Bibliotheken und vorgefertigte Anwendungsdienste zu implementieren. Seit IBM 2016 erstmals einen Quantencomputer in die Cloud stellte, haben Entwickler und Kunden über 700 Milliarden solcher Circuits auf der Hardware ausgeführt. Die Zukunft des Quantencomputings soll das Erlernen einer neuen Programmiersprache und das separate Ausführen von Codes auf einem neuen Gerät überflüssig machen. Circuits sollen so einfach in einen typischen Computing-Workflow integriert werden wie ein Grafikprozessor. So sollen Forscher und Entwickler in der Lage sein, innerhalb eines cloudbasierten Frameworks nahtlos zu arbeiten und so von der Leistungsfähigkeit der Quantencomputer zu profitieren. Bei IBM wird diese Vision als Frictionless Quantum Computing bezeichnet. Experten halten es für möglich, Ergebnisse so zehn- bis hundertfach schneller zu erhalten. Quantencomputern und KI dürften somit auch bei der Bewältigung von Herausforderungen wie der Klimakrise eine herausragende Rolle zukommen.