Vertrauen in künstliche Intelligenz

Akzeptanz schaffen, nur wie?

Unternehmen setzen zunehmend auf KI oder planen, dies künftig zu tun. Doch neben aller Euphorie gibt es bezüglich künstlicher Intelligenz auch Vorbehalte und Unsicherheit. Darum gilt es, die Blackbox der Systeme ein Stück weit aufzubrechen, um die Akzeptanz und auch die Qualität von KI-Ergebnissen zu verbessern.

Bevor KI in Unternehmen und auch in der Gesellschaft auf Akzeptanz stößt, müssen bestimmte Herausforderungen gelöst werden. In der Vertrauenswürdigkeit liegt ein Schlüssel für den Erfolg der Technologie. Ausgehend von der Definition, dass Vertrauen als die subjektive Überzeugung von der Richtigkeit einer Aussage und von Handlungen zu verstehen ist, kann ein KI-System generell als vertrauenswürdig eingestuft werden, wenn es sich für den vorgesehenen Zweck immer in der erwarteten Weise verhält. Daraus lässt sich folgern, dass Vertrauenswürdigkeit nachweisbar ist. In Bezug auf künstliche Intelligenz sind somit grundlegend folgende Faktoren relevant:

- • Die Datengrundlage für den Anwendungsfall muss qualitativ möglichst hochwertig sein.

- • Die IT-Anwendung und das KI-System sind von KI- und Anwendungsexperten konzipiert sowie manipulationssicher und vertrauenswürdig umgesetzt.

- • Eine Nachvollziehbarkeit der Ergebnisse wird ermöglicht.

- • Bei der Entwicklung und Anwendung werden jeweils ethische Grundsätze eingehalten.

Qualität der Eingangsdaten

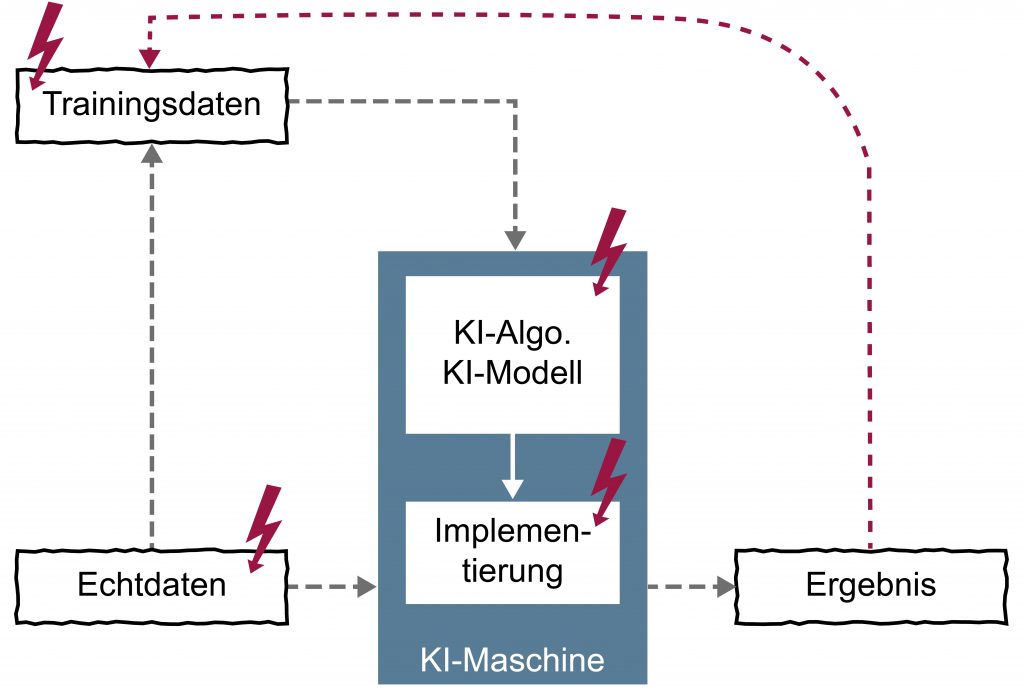

Grundsätzlich basieren Entwicklung und Einsatz von KI-Anwendungen auf Daten. Diese werden beispielsweise benötigt, um einen KI-Algorithmus für dessen spätere Nutzung zu trainieren. Unter dieser Prämisse ist eine differenzierte Analyse der Daten bezüglich ihres Werts und ihrer Aussagekraft im Sinne der Aufgabenstellung ein essentieller Schritt zur Sicherstellung der Vertrauenswürdigkeit von KI-basierten Anwendungen. Denn die Auswahl der Daten sowie deren Qualität tragen maßgeblich zum Endergebnis bei. Aus diesem Grund sollte es obligatorisch sein, entsprechend Positionen im Unternehmen zu etablieren, die für für die Datengewinnung und -nutzung zuständig sind sowie für die Kontrolle der Umsetzung. So lässt sich ein Standard der Datenqualität sowohl etablieren als auch validieren. Im Einzelnen sind dabei unter anderem Vollständigkeit, Repräsentativität, Nachvollziehbarkeit, Aktualität und Korrektheit zu berücksichtigen. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Vollständige Daten

Die Grundvoraussetzung für Vollständigkeit ist, dass ein Datensatz alle notwendigen Attribute und Inhalte enthält. Kann das nicht garantiert werden, entsteht daraus potentiell das Problem von irreführenden Tendenzen, was letztendlich zu falschen oder diskriminierenden Ergebnissen führt. Dieses Phänomen tritt unter anderem bei Predictive Policing-Systemen auf: Wenn beispielsweise die Datenerhebung zu Kriminalitätsdelikten von vorneherein massiv in definierten Stadtvierteln stattfindet und dies im Kontext mit bestimmten Merkmalen wie Herkunft und Alter geschieht, ergibt sich daraus im Laufe der Zeit, dass dort bestimmte Bevölkerungsgruppen stärker überwacht und durch die häufiger durchgeführten Kontrollen letztendlich per se kriminalisiert werden. Der (vermeintliche) Tatbestand kann jedoch unter Umständen lediglich darauf basieren, dass Vergleichswerte unter Berücksichtigung der gleichen Merkmalen aus anderen Stadtvierteln nicht im adäquaten Maße erhoben wurden. Vollständigkeit bedeutet somit keinesfalls, wahllos möglichst viele Daten zu erfassen – entscheidend ist die sachgerechte Auswahl.

Repräsentative Daten

Repräsentative Daten zeichnen sich dadurch aus, dass sie eine tatsächliche Grundgesamtheit und somit die Realität abbilden, die für die Aufgabenstellung geeignet ist. Sind die Daten nicht repräsentativ, kann daraus ein Bias resultieren. Dieses Phänomen tritt beispielsweise im Recruiting von Führungskräften auf, wenn hier größtenteils Daten aus der Vergangenheit berücksichtigt werden und diese beinhalten, dass in einem bestimmten Zeitrahmen überwiegend Männer in Führungspositionen waren. Mit der Konsequenz, dass die KI-basierte Anwendung daraus folgern müsste, dass Männer für diese Positionen qualifizierter seien. Dies zeigt, dass durch KI-Systeme, etwa aufgrund von Repräsentationsproblemen, nicht zwangsläufig die anvisierte Objektivität erreichbar ist.

Nachvollziehbare Daten

Damit die Datenqualität überprüft werden kann, muss deren Quelle nachvollziehbar sein. Sind diese nicht transparent, können die Daten nicht validiert werden, was sich dann potenziell negativ auf die Datenqualität auswirkt. Für eine bestmögliche Bewertung und Messung der Datenqualität als auch der Qualität der Quellen sowie der Ableitung gezielter Verbesserungsmaßnahmen, müssen Vorgaben definiert werden. Dafür gilt es, die für den Prozess relevanten Kriterien wie beispielsweise Konsistenz oder Einheitlichkeit zu bestimmen. Bei der Prüfung der Qualität sind noch zwei relevante Aspekte zu bedenken: Zum einen kommen Daten oft aus unterschiedlichen Quellen mit verschiedenen Formaten, die vor dem Einsatz auf ihre Utilität verifiziert werden müssen. Zum anderen ist die Nachvollziehbarkeit – gerade im Produktionsumfeld – auch durch die Förderung von qualitativ hochwertigen und sicheren Sensoren abhängig.

Aktuelle Daten

Die grundsätzliche Idee beim Maschinellen Lernen oder KI ist die Extraktion von Wissen aus Daten. Daher muss sichergestellt sein, dass die Daten auch die passenden Informationen und Erfahrungen enthalten. Veraltete Daten können zu falschen Ergebnissen führen, daher sollten sie möglichst aktuell sein.